PR-116 "Glow: Generative Flow with Invertible 1x1 Convolutions" Review ()()

PR-116 "Glow: Generative Flow with Invertible 1x1 Convolutions" Review ()()

1. Citations & Abstract 읽기

Citations : 2021.12.27 기준 1,355회

저자

Diederik P. Kingma - OpenAI, Google AI (Adam, VAE)

Prafulla Dhariwal - OpenAI

Abstract

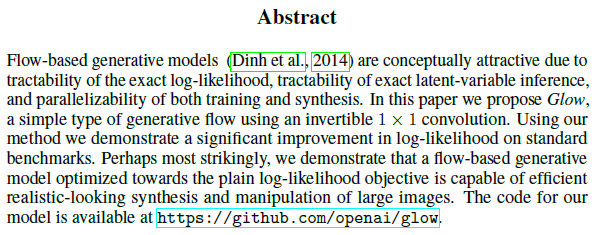

Flow-based generative models (흐름 기반 생성 모델)는 정확한 log-likelihood의 추적성과 정확한 latent-variable inference (잠재 변수 추론), 훈련과 합성 모두의 병렬성으로 인해 개념적으로 매력적이다. 이 논문에서 우리는 invertable 1x1 conv를 사용하는 간단한 유형의 generative flow인 Glow를 제안한다. 우리들의 방법을 사용함으로써 우리는 표준 benchmark에서 log-likelihood의 상당항 향상을 보여준다. 아마 가장 놀라운 것은 일반 log-likelihood objective쪽으로 최적화되는 Flow-based generative model (흐름 기반 생성 모델)이 큰 이미지들에서 사실적으로 보이는 합성과 조작이 효율적으로 가능하다는 것을 증명할 수 있다는 점일 것이다. 우리들의 모델 코드는 아래에서 확인할 수 있다. https://github.com/openai/glow

2. 발표 정리

공식 논문 링크

https://papers.nips.cc/paper/2018/hash/d139db6a236200b21cc7f752979132d0-Abstract.html

Glow: Generative Flow with Invertible 1x1 Convolutions

Requests for name changes in the electronic proceedings will be accepted with no questions asked. However name changes may cause bibliographic tracking issues. Authors are asked to consider this carefully and discuss it with their co-authors prior to reque

papers.nips.cc

https://arxiv.org/abs/1807.03039

Glow: Generative Flow with Invertible 1x1 Convolutions

Flow-based generative models (Dinh et al., 2014) are conceptually attractive due to tractability of the exact log-likelihood, tractability of exact latent-variable inference, and parallelizability of both training and synthesis. In this paper we propose Gl

arxiv.org

Presentation Slide

Contents

Related work

1) Autoregressive models : Simplicity / limited parallelizability of synthesis

2) Variational autoencoders : parallelizability of training and synthesis / challenging to optimize

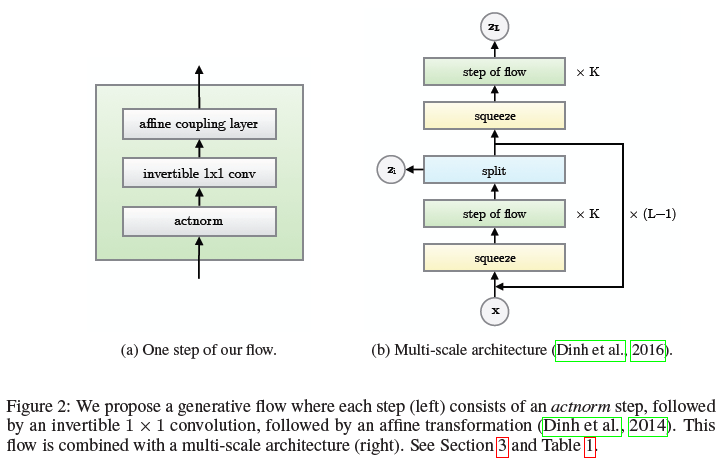

3) Flow-based generative model : NICE, Density estimation using Real NVP, Glow

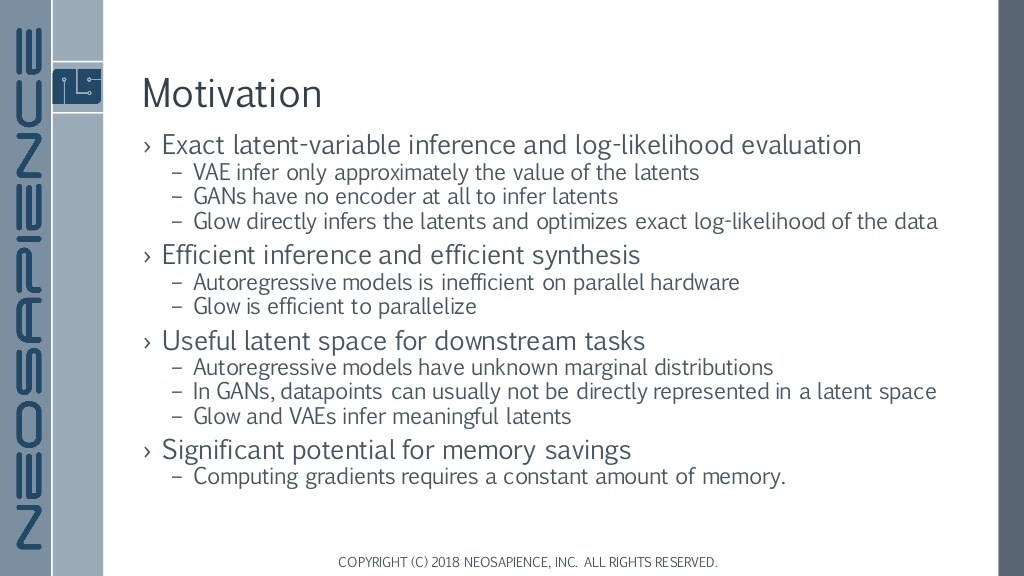

Motivation

1) 정확한 latent variable inference (잠재변수 추론)과 log-likelihood 평가가 가능

2) 효율적인 추론과 합성

3) 유용한 latent space (잠재 공간)

4) 메모리 절약에 상당한 잠재성을 가짐

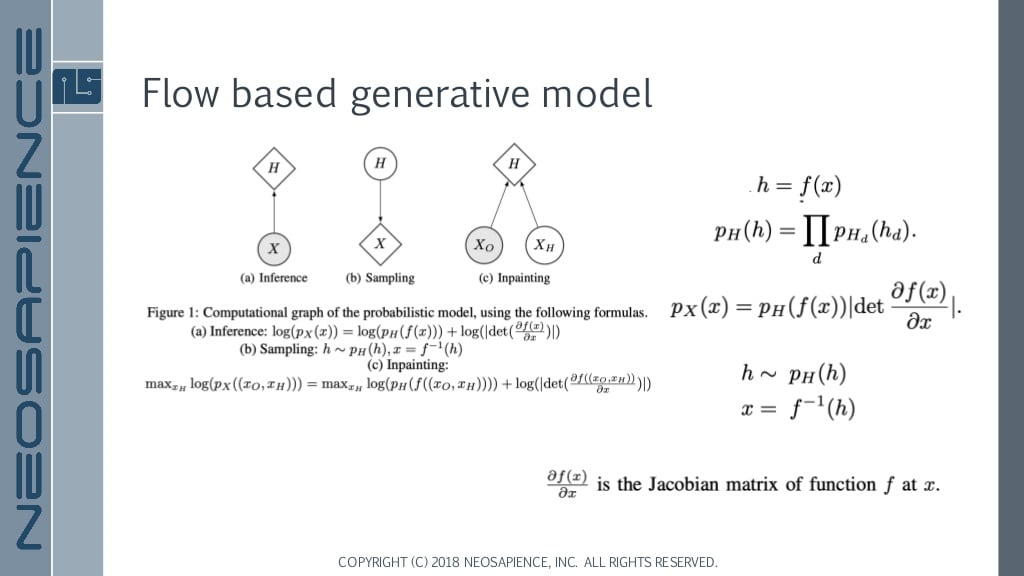

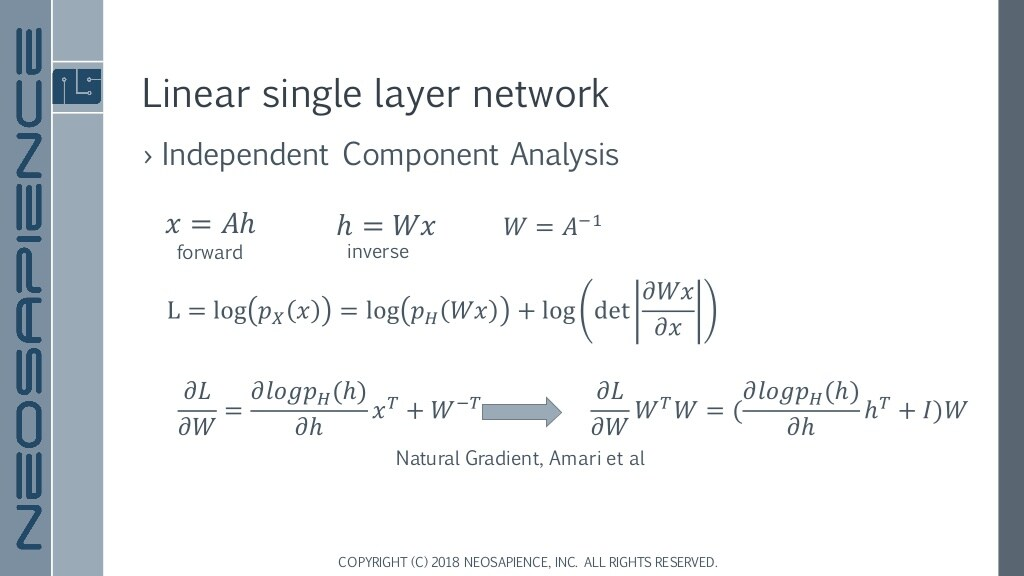

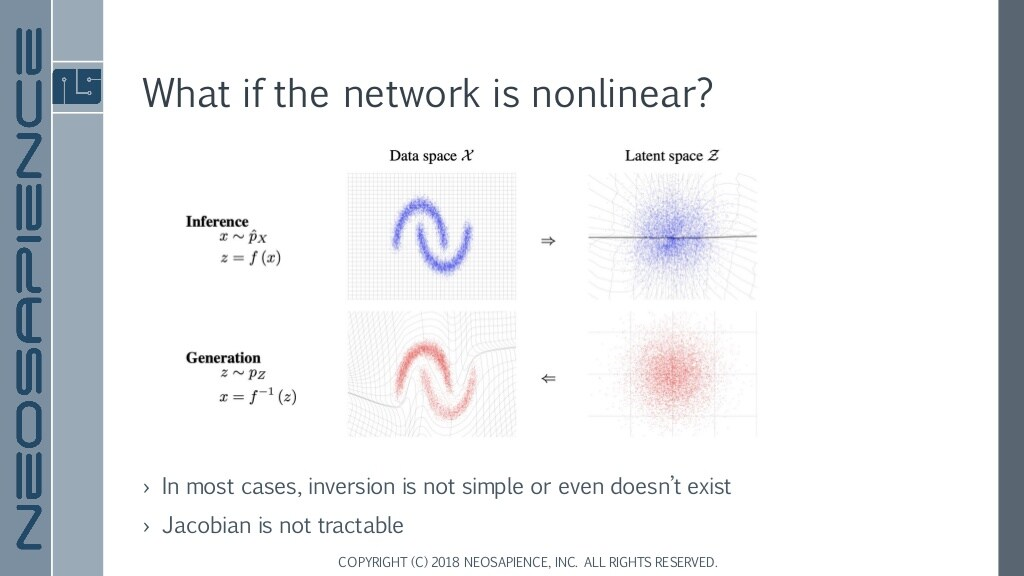

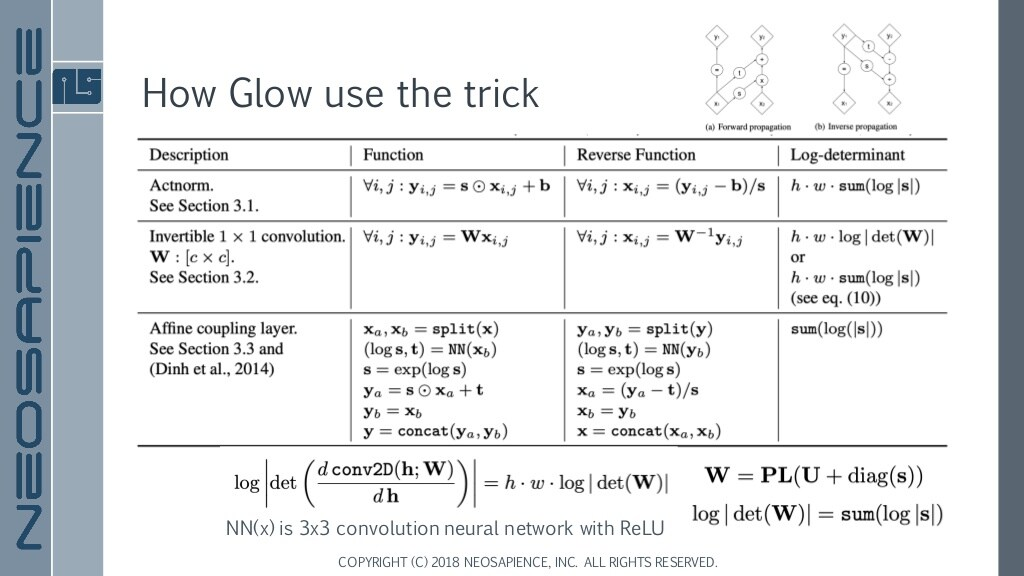

기존 방법론에서는 Jacobian matrix function f의 미분과 Inverse에 대한 계산이 어려웠음.

Non-Linear한 network 혹은 data space의 경우 inversion과 Jocobian 계산이 어려움.

z inference - random sample

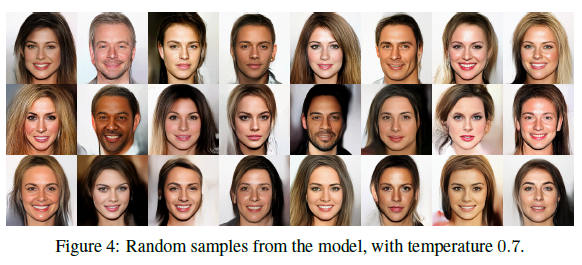

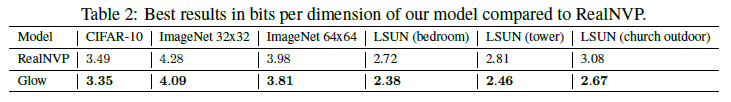

Evaluation 지표도 좋아짐.

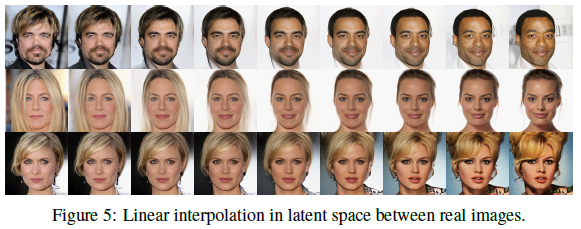

Interpolation의 결과 Fig 5.

Temperature가 낮으면 비슷한 이미지 점점 커지면 Diverse. 그러나 1에 가까워질 수록 이상한 이미지 생김

L layer 개수가 적은 것(4)보다 depth가 커야함(6).

참조

GitHub

https://github.com/openai/glow

GitHub - openai/glow: Code for reproducing results in "Glow: Generative Flow with Invertible 1x1 Convolutions"

Code for reproducing results in "Glow: Generative Flow with Invertible 1x1 Convolutions" - GitHub - openai/glow: Code for reproducing results in "Glow: Generative Flow with Invertibl...

github.com

공식 사이트 참조 내용

Glow: Better Reversible Generative Models

We introduce Glow, a reversible generative model which uses invertible 1x1 convolutions. It extends previous work on reversible generative models and simplifies the architecture. Our model can generate realistic high resolution images, supports efficient s

openai.com

https://cdn.openai.com/research-covers/glow/videos/both_loop_new.mp4

블로그

https://sanghyu.tistory.com/18

Glow: Generative Flow with Invertible 1X1 convolutions 논문 리뷰

논문은 이곳에 링크를 걸어두겠다. 동아리에서 논문세미나(WaveGlow)를 했던 내용으로 발표영상도 있으니 참고하면 좋겠다. 순서로는, 생성모델의 종류를 알아본다. flow기반 방법을 이해하기 위

sanghyu.tistory.com

추가 영상